围绕老年人健康管理、风险预警、照护辅助等需求,构建全场景智能感知网络,实现机构、社区、居家环境中的 多模态健康监测。基于物联网技术和多模态数据感知,构建了老年人体征、行为、语音、图像等信息的主动感知系统,支撑老人健康计算和老人智能照护的发展。包括:

l 非接触式心血管感知:通过视频成像和光电容积描记术,从面部视频中提取心率、脉搏等心血管参数,适用于多种居家场景,具备无扰、长时程监测的优势。

l 多模态心理感知:通过视频、传感器等获取生理(如心跳、呼吸)和行为(如面部表情、语音)等多模态数据,进而感知心理状态,适用于心理诊疗、教育、司法等不同领域。

l 无源情感感知:通过无线信号感知肢体动作,识别情绪并分类,避免了传统视觉或传感器系统的隐私和舒适度问题,其非接触式设计提高了适用性。

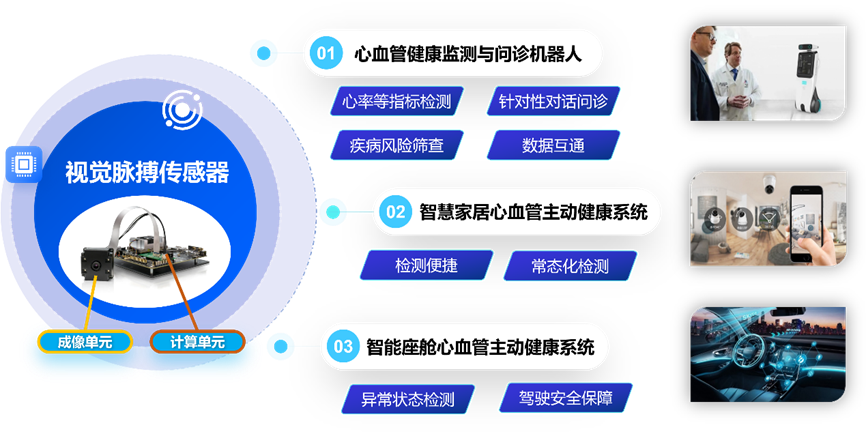

(1)视频非接触式心血管监测

基地响应《健康中国行动―心脑血管疾病防治行动实施方案(2023―2030年)》中的“完善从心脑血管疾病预防、高危人群筛查到早期诊断、规范化治疗以及康复服务的一体化全流程管理”要求,与以色列维特尔公司、新加坡国立大学等合作,突破光电容积视频分析技术,进而研发视频非接触式心血管主动健康管理系统。

系统包括“测-评-控”三项核心技术,服务于居家心血管健康全方位管理:(1)心血管参数监测技术:采用成像式光电容积描记术,从视频中提取脉搏、心率等参数;(2)疾病风险筛查技术:根据用户个人的心血管参数变化趋势,采用临床大数据与深度学习方法,对房颤、动脉硬化等疾病风险做出个性化评估;(3)调控处方生成技术:基于心血管健康测评结果,结合新安中医药食同源知识库训练垂类大模型,从营养、运动等方面生成健康调控处方。系统能够在无扰无感的情况下提供长时程的心血管健康监测,对于老年群体更加友好。此外,系统可以在不增加成本的前提下嵌入于家用监控、智慧电视屏、智能手机等终端,在多种居家场景中灵活应用。

视频非接触式心血管主动健康管理系统框架

视频非接触式心血管主动健康管理系统应用

基地与蔚来汽车合作,将系统嵌入到智能座舱中,已通过蔚来测试中心的实车上路测试。团队与中科大附属第一医院心内科合作,系统在心脏康复中心取得试点应用,测试超1000人次。研究成果被《中国科学报》、《芬兰Kaleva新闻》等国内外媒体采访报道,获“挑战杯”一带一路国际邀请赛银奖、“挑战杯”全国大学生课外学术科技作品竞赛二等奖。

视频非接触式心血管主动健康管理系统的部分荣誉

(2)基于多模态融合的心理感知与计算平台

基地在国家重点研发计划等项目的支持下,与新加坡国立大学、新加坡管理大学等合作,突破多模态数据融合技术,进而研发了基于多模态融合的心理感知与计算平台,形成了基于多模态融合感知的中长时心理计算与风险预测模型、基于短时认知反馈的人格探测模型、基于交互的心理干预模型,构建了普适心理计算与交互干预技术体系,带动了人工智能与心理学交叉领域的发展。在理论上创新性的提出基于多模态交互的心理量化和引导,为基于多模态情绪引导和心理干预奠定了基础;并提出了面向情绪引导的多模态内容生成框架。在技术上,综合生理和行为等多通道,包括面温、心跳、呼吸、面部表情、语音和肢体动作等多个通道的多模态信息,实现了基于情感交互的多策略个性化心理干预,基于情感状态转移张量网络理论,多模态交互与内容对抗生成,实现心理的个性化干预。在心理诊疗、教育和审讯等场景有广泛应用。

该成果孵化了国家高新技术企业“合肥中聚源智能科技有限公司”,已获得创谷资本、合肥创投、合肥天使投资基金等机构的战略投资,产品已应用于公安、检察、司法、军队、政府、教育等行业,获2023全国通用人工智能创新应用大赛一等奖。汪萌教授获评2024年科学探索奖、第十七届中国青年科学家奖。成果产生了突出的国际学术影响。获得2023年度中国图象图形学会自然科学奖二等奖;获吴文俊人工智能科学技术进步奖三等奖1项,中国发明协会发明创业成果一等奖1项,教育部高等学校科学研究优秀成果奖科学技术进步一等奖1项等。提出的视觉特征提取和多模态融合方法获得CCF A类会议ACM MM2023多模态情感分析挑战赛“复杂个性化情感检测”赛道第一,提出的基于注意力的多模态特征融合模型获得CCF A类会议ACM MM2023多模态情感分析挑战赛“幽默检测赛道”第一名。所研制装备“非接触动态实时心理测评系统”进入中国科学技术协会《2019年前沿领域科技成果推介手册》。项目成果入选司法部“智慧司法,数字法治”建设工程,并在全国14所监狱、看守所、戒毒所应用并取得良好效果。

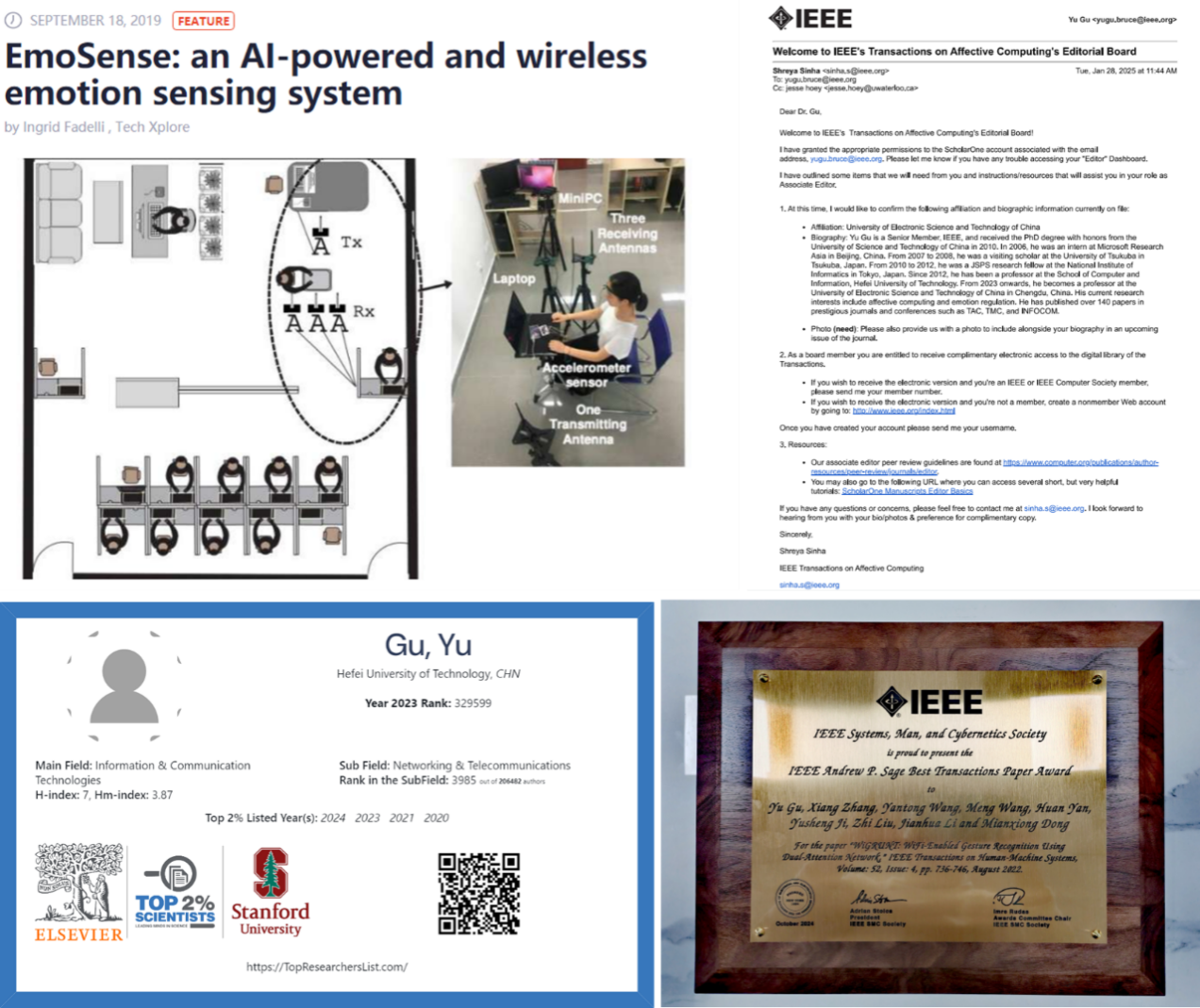

(3)无源情感计算系统EmoSense

基地在安徽省重点研发计划国合专项的支持下,与日本静冈大学等高校研究开发的一种基于肢体语言的独特的情绪感知系统——EmoSense。日常生活中,人类可以通过面部表情、语言交流以及肢体语言等多种途径来表达情绪。而在先前的研究中发现,使用无线进行行为检测和动作感知时,人类的肢体动作会通过遮挡或多径效应等方式影响无线信号传输。而这些信号效应会在时频域中根据不同的肢体动作形成不同的信号波形和指纹。因此,基于先前研究支持,开发了一种基于无线通道的,对肢体语言进行识别以实现情绪感知分类的系统——EmoSense。现有的大多数基于视觉或传感器的情感识别系统要依赖于专用硬件或因为视频隐私或者佩戴舒适度的问题影响其在现实环境中的适用性。而EmoSense通过无线信号进行动作感知分类情感,这种非接触式低隐私侵犯性的设计很大程度上提高了其适用性。

该成果被国外科技媒体Tech Xplore进行了专题报道,获得2024年度Andrew P. Sage最佳汇刊论文奖(IEEE Andrew P. Sage Best Transactions Paper Award),谷雨教授连续三年入选信息与通信技术领域Top 2%名单,担任了lEEE's Transactions on Affective Computing副主编。